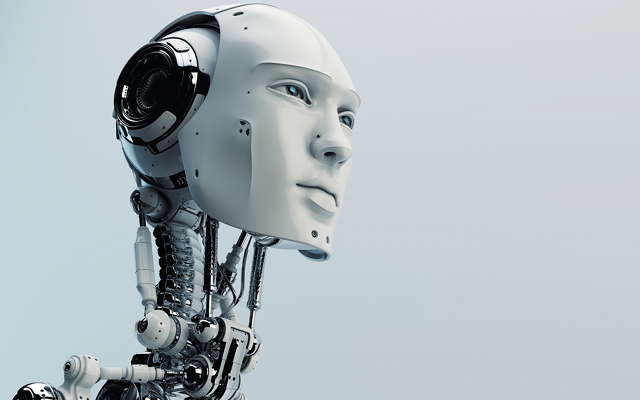

霍金、穆斯克、盖茨,为何这些科技领袖都在担心人工智能?

人工智能,它是不是代表着一种对人类的“生存威胁”?有些非常聪明的人确实是这么认为的,比如埃伦·穆斯克(Elon Musk),史蒂芬·霍金(Stephen Hawking),比尔·盖茨(Bill Gates),山姆·奥特曼(Sam Altman),尤其是牛津大学教授尼克·伯斯特伦(Nick Bostrom),他的一本名为《超级智能》(Superintelligence)的著作让穆斯克有感而发,在Twitter上发了好多条推文。技术专家按说都应该是些理性主义者,但是穆斯克却给人工智能叛逆者的威胁性增加了一层超自然色彩。去年10月份时,他在美国麻省理工学院(MIT)告诉听众:“我们这是在孕育恶魔。”

伯斯特伦到未必是把人工智能看成如恶魔那般邪恶。他思考得更多的是风险与机率。在2002年的一篇论文里,他将生存威胁定义为“其中的不利结果要么会毁灭地球上自然孕育的智能生命,要么会永久和严重地削弱地球智能生命的发展潜力”。在他看来,这些风险值得我们加以抑制,哪怕它们的发生几率非常之低,因为潜在的代价实在是太大了。这种灾祸的根源既可能是刻意为之,也可能纯属意外,并且可能会源自许多领域,包括生物技术、纳米技术,以及人工智能。

那么为何所有的矛头都指向了人工智能?我们无疑正处于机器智能在性能和估值上的急剧上升期。根据我在今年年初时所观察到的,深度学习如今已经走进了许多科技领军企业。但是在发生了类似廉价航空德国之翼(Germanwings)的9525航班坠毁等事件之后,比起威胁到全人类的存在来说,机器智能似乎更可能被用于保护我们免受人类不当行为的侵害。

我个人对于这种畏惧心理的研究则让我得出了这样的结论:问题的关键其实更平凡、也更容易预料,那就是监管。我从最近加入了人工智能大辩论的科技界领袖那里选出了一些代表性的言论,其中最让我担忧的,反而是这些言论中透露出的为了避免出现意外后果而求助于监管的心理。穆斯克在将人工智能定性为“我们最大的生存威胁”后,就说了这样的话:“我们应该采取一些管理和监督措施,可以是国家级或者国际性的,”他警告称,“这只是为了确保我们不会干出一些蠢事。”而与监管相比,对于全人类生存受到威胁的畏惧心理,反倒是这份言论清单上最不相干的概念。

首先,我要先说明,我也是一直在为这道难题抓耳挠腮的人之一。世上似乎还存在着许多比追捧“奇点”降临论更为紧迫的问题。与此同时,我也无比尊重其他那些可能懂得我并不了解的东西的人。想到那些“其他人”有的是霍金那样的天才,有的是穆斯克那样具有远见卓识的业界领袖,有的是盖茨那样的慈善家,有的是奥特曼那样的科技界业内部人士时,你就应该停下来好好反思一下。或许这完全已经远远超出了我们这些凡人所熟知的范畴?

另一方面,这些以最引人注意的方式敲响了警钟的人当中,没有一个是本身真的在做人工智能项目的。对这个领域投资的人是有,但是没有本身就在做这个的。所以,当Numenta公司的人工智能先驱杰夫·霍金斯(Jeff Hawkins)以回复的形式,在一本名为《终结者不会降世。未来将会感谢我们》(The Terminator Is Not Coming. The Future Will Thank Us)的书中写下了十分博学的反驳时,我把这看作是一个良性的信号。霍金斯研究人工智能带来的问题已有30多年,他一再向读者保证道:“我并没有其他人那样的顾虑,因为他们的想法建立在三大误解的基础上。”然后他解释道,智能会催生自我复制和自我意识在逻辑上是不成立的,而就算是人工智能也必须遵从物理定律。

霍金斯对这些畏惧心理的批判中,核心的一点便是他对“智能”这一定义的理解。我为了本文特意采访了霍金斯,然后暂时搁笔去读了他的著作《论智能》(On Intelligence;2005年出版)。我在这里透露一些内容给大家:与笛卡尔“我思故我在”的论调截然相反,存在并不是由思想产生的。我思,且我在。这两件事是同时发生,而不存在因果性。在霍金斯看来,智能是发生在大脑新皮质上的活动,并且(用他在书中的原文来说)“意识不过是拥有大脑皮质所带来的感觉而已”。但是对智能机器的建造(霍金斯就正在致力于此),并不意味着这些机器会是有意识、有知觉,或者拥有自我复制能力的。

拥有知觉的机器或许真的会在某一天成为可能,而如何控制、约束或鞭策这些“生物”的情境,才是伯斯特伦面对超级智能所关心的核心问题所在。但是霍金斯为这场争论带来的则是他的如下主张:创造拥有自我感知的机器是一个与制造智能机器截然不同的问题。而这就是人工智能的当前使命。伯斯特伦的“约束”难题,只有在智能机器拥有了拓展自身力量的动机时,才会变得至关重要。

另一种温和的观点来自穆斯克的多年好友、作为“PayPal帮”一员的彼得·泰尔(Peter Thiel)。在去年于都柏林举行的网络峰会(Web Summit)上,泰尔在一场访谈中探讨了超级智能的政治意义,将之与外星人登陆地球相比较。

如果外星人明天就会登陆地球,首要的问题不会是这对经济而言意味着什么。首要的问题会是政治层面的。他们是友好的吗?他们是有敌意的吗?而我认为,围绕着人工智能提出的政治问题是很重要的,我也认为,我们对这个问题的直觉还很不发达。

不仅我们这些凡人对于这一威胁缺少直觉,就连泰尔都觉得这个问题太过遥远。“我仍然认为这个问题属于十分遥远的未来。我的猜测是这会出现在一个世纪或更久以后。所以虽然我觉得这是个非常重要的问题,但也是一个我不会现在就为之担忧的问题。”那么为何这些科技界领袖还会有这些担忧,甚至还在最近的西南偏南音乐节(SXSW)上出现了反机器人的海报呢?泰尔将原因直接归结于大众对科技的普遍畏惧与误解。泰尔对网络峰会上的听众们说:“我有一条反向信念,认为我们其实并非真正生活在科学或技术的时代。而我们当中那些从事科学和技术工作的人,才是我们当今社会的反主流文化。”

提到好莱坞的科幻影片,泰尔认为,“它们全都是在描绘一种根本不成立的技术,要么是杀人的,要么是反乌托邦的,要么是毁灭世界的。”按照卡纳曼(Kahneman)的说法,这些机器人和反叛的人工智能的形象是存在于我们的幻想之中的。因此科技行业所面临的挑战,就是要让类似于霍金斯的智能机器这样的愿景变得比“终结者”更加可能、更加生动//更加值得信服。在这一点上,好莱坞影片同样也能贡献一份力量。

人工智能,或者更恰当的说法是机器智能,与合成生物学拥有太多共通之处。两者都拥有强大的力量,可以为人类带来巨大帮助。两者都会在流行文化中激发歇斯底里的情绪。无论是这两种情况的哪一种,我最关心的都是那些可能会滥用科技的人类败类,而非这些科技产品本身的邪恶能力。

记住一点会对这种针对科技的非理智恐惧大有裨益,那就是:世间万物,无论是不是人类制造出来的,都要遵从物理定律。阿德里安·贝扬(Adrian Bejan)在其著作《自然中的设计》(Design in Nature)中指出,自然界和科技界共通的一项客观事实就是,它们都属于不断向前运动的系统。在完全自由的情况下,这些系统会随着时间推移而不断演进,增加系统中流动介质的流量。电子、人口、货币,全都遵从着同样的原理。对贝扬书中这一观点所做出的一种推论是,所有的增长轨迹都是遵循S曲线的。因此,不像那种任何进程均可无止境演进的纯数学模型,物理模型是会强行加入各种约束的。

数学与自然科学之间的这些交锋,正是我在当今围绕人工智能展开的争论中所看到的那些层出不穷的冲突所在。虽然深度学习植根于20世纪90年代建立在生物学基础上的神经网络学,但当代的年轻实践者们却是默认以一种更偏向数学化的思维来研究它。如果你没有经历过神经网络时代的美好未来以及后来的幻灭,那或许就会相信当代技术的潜力是无止境的。

迄今为止,对霍金斯的结论抨击得最为激烈的人士之一是雅恩·乐库(Yann LeCun)。乐库是最早的神经网络研究者之一,如今已经成为深度学习运动中最为重要的人物之一。他目前是Facebook的人工智能主管。去年5月份在新闻网站Reddit上举办的一次“随便问”(AMA)活动上,乐库提醒大家,切莫低估霍金斯“要将这些概念实例化和简化至现实可操作”时所要面对的难度。对于Numenta公司的分层式即时记忆(Hierarchical Temporal Memory)算法,他提出了一个问题:它们是“在将目标功能最小化吗”?

在这一点上,由谷歌(Google)的杰弗里·辛顿(Geoffrey Hinton)、百度的吴恩达、Facebook的乐库、微软还有其他人员机构所开发的深度学习技术,则已为具体分类工作(比如在视觉数据库ImageNet中识别出猫的图片)的解决提供了最高的精确度。这些系统一直能够用扩大规模的办法来提升表现,说明以数学性思维来进行研究还能不断取得的进步。但是这些方法已被证明并不牢靠,它们会对图片的像素进行细微的改动,或是在文字中插入不相干的词汇,这说明这些系统其实并没有真正“理解”它们所在处理的是些什么。乐库自己也在去年12月份的数据驱动会议(Data Driven Conference)上讨论过穆斯克的那番“生存威胁”言论。他对现代人工智能的处境表达了一种非常中立也非常慎重的看法。“还有一些基本问题我们尚未搞清楚。在不断前进的过程中,我们还会遭遇很多技术难关,”他说,“深度学习为我们带来了许多希望,我们正在这些方面取得进展。我们并不知道下一道壁垒会在哪里出现……还有很多取得进展的机会。我们目前尚不了解这个领域的极限在哪里。”

乐库和霍金斯都是人工智能大战中久经考验的战士,他们充满激情,但也不乏小心谨慎。人工智能领域出现过许多转瞬即逝的潮流,眼下的种种成就中或许也有很多会有朝一日沦落成其中的一员。IBM刚刚宣布,它已经成立了一支100人的团队,来测试Numenta公司的算法,并在尝试制造相应的硬件设备,用来支持将霍金斯研究出的大脑皮层工作原理模型实例化所需要的大规模并行计算。乐库也认为霍金斯“拥有正确的直觉和正确的哲学”。乐库还列举了“无监督表达学习(unsupervised representation learning),尤其是用于处理基于预测的时序及次序信号的方法”,这正是Numenta公司的方法所专擅的领域,也是有待年轻工程师探索且前景看好的领域之一。时序数据将是未来物联网的标志所在,创造出有别于大数据现有形式的需求。这会为搭建能够基于储存量越来越大的静态数据实现动态预测的模型带来价值优势。就像霍金斯对我说的,“未来可能更像是Snapchat,而非Facebook”。

于是这又把我们带回到了监管的话题上。如果机器智能在本质上就是对外部数据流的预测和响应,那还有什么可监管的呢?就这一点来说,答案并不是人工智能本身,而是人类置放数据的用途。这个答案是正确的,但对那些抱怨监管会扼杀创新的科技公司而言,却也是个无可厚非的痛点。

我并不认为穆斯克或其他那些人是在不负责任地指责人工智能的威胁性,但是这种姿态已经导致大众的视线从科技公司人员为世人带来的影响上转移开了。就像我曾经就生物技术发表过的看法一样,最能降低公众对新技术的畏惧心理的,就是让他们看到新技术能为许多人带来的显著福祉。煽动针对人工智能的畏惧心理会带来预想之外的副作用,那就是政府或许会出于群情激动的公众所施加的压力,而施行适得其反的监管措施。埃伦·穆斯克曾捐助1,000万美元建立生命未来研究所(Future of Life Institute),用于研究人工智能威胁性。从许多意义上来讲,我认为它既是技术专家和科学家们试图在政府对其做出监管之前先行尝试自我监管的努力,同时也不是。

热门文章

-

1

从OTA到OTS,旅游渠道新模式从概念到落地,服务中心全面开花

-

2

Lululemon 谈独特的品牌文化

-

3

B站和迪士尼看似风马牛不相及,但确实有一些相似之处

曹立 -

4

阿里妈妈漫天:消费升级的环境下,营销快速变革的三大核心命题

-

5

人民日报副总编辑马利:年轻人在哪里,新媒体的未来就一定在哪里

-

6

共享充电桩,会成为下一个资本追逐的风口吗?

-

7

超半数中国消费者认为,智能手机是最重要的购买决策媒介

-

8

微信影响力报告:微商为什么行不通?权威数据告诉你真相!

-

9

WIFI入口(三):WiFi是免费的?隐形冠军Exands不这样看!

-

10

网络型的仓储服务公司会是行业新的主赛道吗?

-

11

余承富:互联网云模式是安防市场的必然趋势

-

12

宗宁:免费时代已过,如何把握收费时代红利?

-

13

旅游新零售:旅企的线上线下融合势在必行?

-

14

马云说电商要变天:50张PPT全面解析未来商业新常态

-

15

中科创星米磊:硬科技挣的是慢钱,但走得更长远

路途 -

16

知识手艺人新模式迎拼粉时代,新模式电商渐获丰收

-

17

流量贵之不堪言,创业者每天都是生死存亡

-

18

汇丰银行分析师:单品牌战略或被淘汰,更多家族企业将开展品牌并购

蒋晶津 -

19

浅谈农产品B2B的优势与劣势

-

20

消费升级时代:你每一次付账,都是自己生活方式的一次选择